En general, el término supervisión se emplea en las políticas públicas a diferentes niveles, e implica transparencia institucional, responsabilidad pública o intervención en los resultados. Esas implicaciones son difusas, pero ni la normativa actual ni las que se han propuesto ayudan a definirlas. En el contexto de este informe sobre políticas públicas, proponemos la siguiente definición: Por supervisión humana se entiende, principalmente, la capacidad de actuación de los supervisores u operadores humanos en un sistema (basado en algoritmos) para mitigar los daños o errores causados por el sistema.

La normativa, hasta ahora, refleja una comprensión superficial de la interacción persona-máquina. Por ello, para minimizar eficazmente los daños por sesgos y discriminación en la toma de decisiones, ya provengan de las personas o de los algoritmos, los responsables políticos deben entender primero los riesgos y la complejidad que comporta el uso de ADMS y de qué manera puede desempeñar un rol significativo la supervisión humana.

Este documento trata de analizar la complejidad que hay detrás de la supervisión humana, tanto en su definición como en su regulación y puesta en práctica. Dado que existe un gran debate en torno a cómo debería regularse la interacción entre personas y algoritmos, y en torno si la supervisión humana requerida actualmente basta para mitigar los daños producidos por los algoritmos, este informe sobre políticas públicas contribuye a dicho debate, explorando la normativa y el campo de estudio de la interacción persona-ordenador, a fin de proponer recomendaciones que puedan ayudar a que las personas participen de un modo significativo.

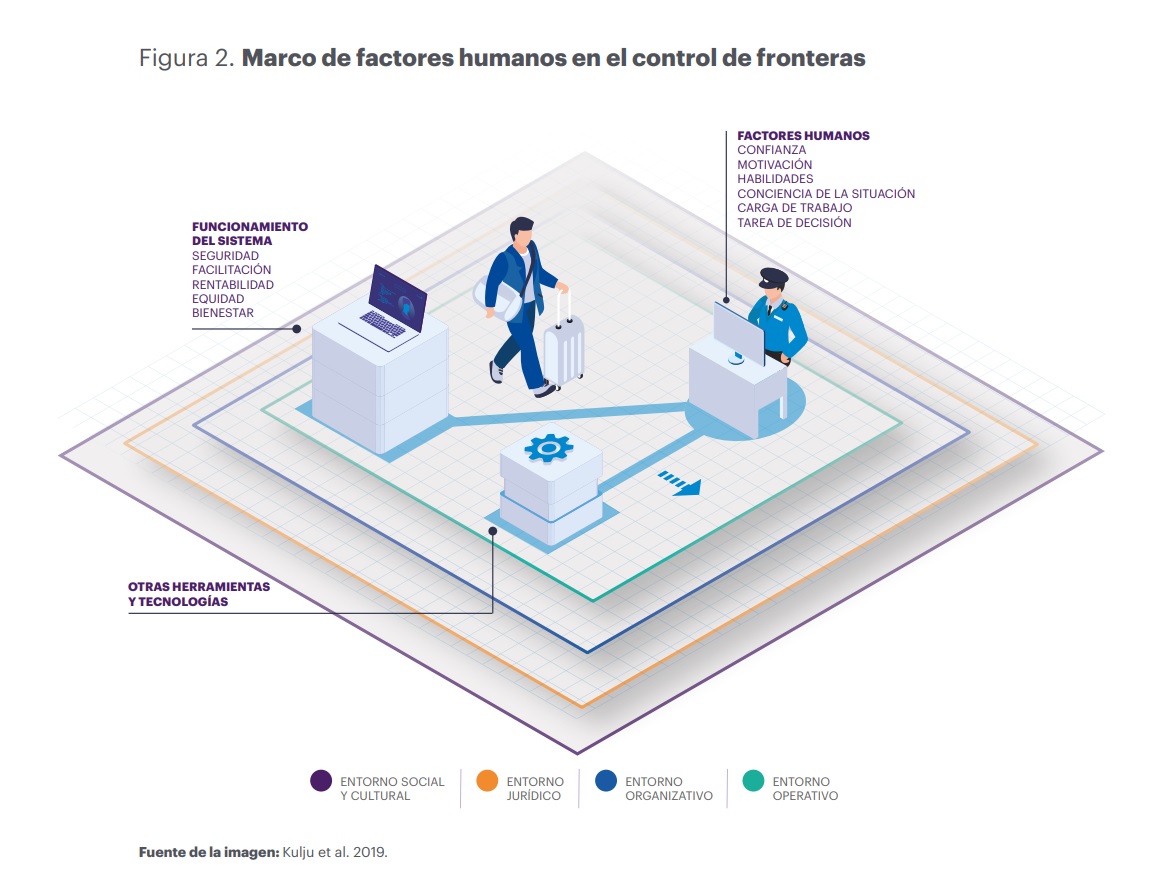

Para entender el complejo contexto de la toma de decisiones, los especialistas del ámbito académico subrayan la importancia de considerar los numerosos niveles que abarca el uso de herramientas automatizadas de toma de decisiones. Comprender esta complejidad requiere estudiar cómo se comportan e interactúan las personas con las máquinas y, también, identificar el entorno organizativo, jurídico y sociocultural.

En este contexto, hay factores humanos que deben tenerse en cuenta, como la carga de trabajo de los operadores humanos, su motivación, su seguridad en sí mismos y su confianza en la herramienta automatizada. Por otra parte, también se debe atender al funcionamiento del propio sistema, que puede abarcar aspectos como su transparencia, su eficacia como herramienta, etc. (Ananny y Crawford 2018; Kemper y Kolkman 2019; Zhang et al. 2020; Lee y See 2004).

Para la regulación, una supervisión significativa consiste en que los operadores ejerzan su poder de actuación siendo conscientes de los sesgos o las limitaciones del sistema (y de los suyos propios). Esto implicaría que los operadores humanos pudieran evitar los daños entendiendo cuándo se equivoca un algoritmo, comprender por qué un algoritmo ha tomado una determinada decisión y considerar los sesgos potenciales del sistema. Por ello, en teoría, para que la supervisión humana sea eficaz, el diseño del sistema también debe tener en cuenta las limitaciones y los sesgos de los operadores humanos.